主要是留存资料方便查看。其实做ZNSSSD研究读驱动没有太大必要。

古猫先生所阅读的NVMe从Kconfig和Makefile来看,了解NVMe over PCIe相关的知识点,主要关注三个文件:core.c, pci.c, scsi.c.

1.概述与nvme_core_init函数解析

打开core.c文件,找到程序入口module_init(nvme_core_init),

1 | int __init nvme_core_init(void) |

从上面的code来看,nvme_core_init主要做了两件事:

- 调用__register_chrdev函数,注册一个名为”nvme”的字符设备.

- 调用class_create函数,动态创建设备的逻辑类,并完成部分字段的初始化,然后将其添加到内核中。创建的逻辑类位于/sys/class/.

在注册字符设备时,涉及到了设备号的知识点:

一个字符设备或者块设备都有一个主设备号(Major)和次设备号(Minor)。主设备号用来表示一个特定的驱动程序,次设备号用来表示使用该驱动程序的各个设备。比如,我们在Linux系统上挂了两块NVMe SSD. 那么主设备号就可以自动分配一个数字(比如8),次设备号分别为1和2.

例如,在32位机子中,设备号共32位,高12位表示主设备号,低20位表示次设备号。

注册字符设备之后,可以通过open,ioctrl,release接口对其进行操作。nvme字符设备的文件操作结构体nvme_dev_fops定义如下:

1 | static const struct file_operations nvme_dev_fops = { |

其中:

nvme_dev_open通过代表设备的inode来获取设备号,然后遍历nvme_ctrl_list(所有的nvme设备都会加入这个list)找到对应的nvme设备,然后做一系列检查,最后找到的nvme设备放到file->private_data区域。file指针也是参数传进来的。nvme_dev_release比较简单,就是用来释放open()函数中申请的资源。nvme_dev_ioctl中实现了5种命令。其中就包括Admin、IO命令(有一点需要注意的是,NVME_IOCTL_IO_CMD不支持NVMe设备有多个namespace的情况)。除了这两种,还有NVME_IOCTL_RESET和NVME_IOCTL_SUBSYS_RESET 通过nvme的ops直接写register来Reset Ioctrl和Ioctrl_subsys。这个nvme的ops名字叫做”nvme_ctrl_ops“, 这个ops在nvme初始化中调用nvme_probe()时赋值为”nvme_pci_ctrl_ops“。。。。这里就没继续看了,毕竟只是做大概了解。

2.NVMe初始化

这次关注的是Pci.c,找到入口 module_init(nvme_init):

1 | static int __init nvme_init(void) |

主要分为两部分工作:创建全局工作队列和注册NVMe驱动。

创建全局队列应该不用看。。。。

注册过程是,调用kernel提供的pci_register_driver()函数将nvme_driver注册到PCI Bus

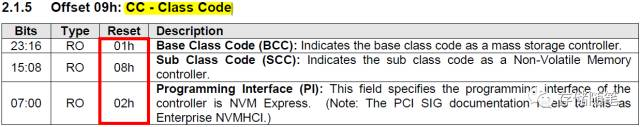

系统启动时,BIOS会枚举整个PCI Bus, 之后将扫描到的设备通过ACPI tables传给操作系统。当操作系统加载时,PCI Bus驱动则会根据此信息读取各个PCI设备的Header Config空间,从class code寄存器获得一个特征值。class code就是PCI bus用来选择哪个驱动加载设备的唯一根据。NVMe Spec定义NVMe设备的Class code=0x010802h, 如下图。

根据code来看,nvme driver会将class code写入nvme_id_table,nvme_id_table中会有相应的属性。这块儿应该不用懂。 反正会有定义0x010802h 代表的NVMe设备逻辑类。

1 | static struct pci_driver nvme_driver = { |

pci_register_driver()函数将nvme_driver注册到PCI Bus之后,PCI Bus就明白了这个驱动是给NVMe设备(Class code=0x010802h)用的。

到这里,只是找到PCI Bus上面驱动与NVMe设备的对应关系。nvme_init执行完毕,返回后,nvme驱动就啥事不做了,直到pci总线枚举出了这个nvme设备,就开始调用nvme_probe()函数开始干活咯。

3.nvme_probe()

同样定义在pci.c中:

1 | static int nvme_probe(struct pci_dev *pdev, const struct pci_device_id *id) |

总结:

- 为dev,dev->queues分配空间。为每个cpu core分配一个。queues为每个core分配一个io queue,所有的core共享一个admin queue。这里的queue的概念,更严格的说,是一组submission queue和completion queue的集合。

调用nvme_dev_map获得PCI Bar的虚拟地址。

初始化两个work变量,定时器,互斥锁,完成量。

- 调用nvme_setup_prp_pools设置DMA需要的PRP内存池。

- 调用nvme_init_ctrl初始化NVMe Controller结构。

- 通过workqueue调度dev->reset_work,也就是调度nvme_reset_work函数,来reset nvme controller。

3.1 nvme_dev_map

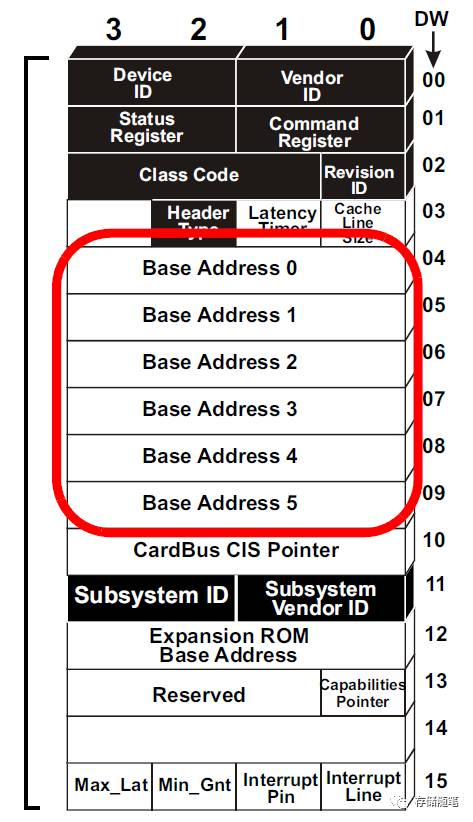

在 PCI 设备中,BAR(Base Address Register,基地址寄存器)用于指定设备希望映射到主内存中的内存量,并在设备枚举后保存映射内存块开始的(基)地址。一个设备最多可以拥有六个 32 位的 BAR 或将两个 BAR 组合成一个 64 位的 BAR。BAR 的值由系统软件(例如 BIOS 和操作系统内核)设置。当系统软件知道设备在地址空间方面的需求时,它将为该设备分配一个适当类型(IO、非预取式 MMIO 或预取式 MMIO)的可用地址范围。然后,系统软件将分配给设备的起始地址写入 BAR 寄存器。

一旦 BAR 的值确定了,其指定范围内的当前设备中的内部寄存器(或内部存储空间)就可以被访问了。当该设备确认某一个请求(Request)中的地址在自己的 BAR 的范围内,便会接受这请求。

假设有一个 PCI 网络适配器,它需要 256 字节的内存来存储其寄存器。在设备枚举期间,系统软件(例如 BIOS)将查询该设备的 BAR 以确定其内存需求。然后,系统软件将为该设备分配一个 256 字节的内存块,并将该内存块的起始地址写入设备的 BAR。

一旦 BAR 的值确定了,操作系统就可以通过读写该内存块中的地址来访问网络适配器的寄存器。例如,如果操作系统想要读取网络适配器的状态寄存器,它可以读取内存块中与状态寄存器对应的地址来获取该信息。

而对于容量大的块设备,例如硬盘驱动器,通常不会将其所有空间都映射到内存中。相反,操作系统会使用其他技术来访问设备的数据。

例如,在访问硬盘驱动器时,操作系统会使用 I/O 操作来读写硬盘驱动器的寄存器。这些寄存器用于指定要访问的扇区号、传输的数据量以及要执行的命令等信息。然后,硬盘驱动器会根据这些信息执行相应的操作,并通过 DMA(Direct Memory Access,直接内存访问)将数据传输到主内存中。

因此,对于容量大的块设备,操作系统并不需要将其所有空间都映射到内存中,而是使用 I/O 操作和 DMA 来访问设备的数据。

设备枚举是指计算机启动时,系统软件(例如 BIOS)扫描系统总线以识别连接到计算机上的所有设备的过程。在设备枚举期间,系统软件将读取每个设备的配置信息,包括设备 ID、厂商 ID 和 BAR 等信息。然后,系统软件将为每个设备分配资源,例如中断号、DMA 通道和内存地址空间。最后,系统软件将这些信息保存在设备的配置空间中,以便操作系统在启动时可以访问它们。枚举设备就是调用 probe。

BAR(Base Address Register,基地址寄存器)位于 PCI 设备的配置空间中。配置空间是一个设备内部的特殊存储区域,用于存储设备的配置信息,包括设备 ID、厂商 ID 和 BAR 等信息。系统软件(例如 BIOS 和操作系统内核)可以通过读写配置空间来获取和设置设备的配置信息。

当系统软件为 PCI 设备分配内存地址空间时,它会将分配给设备的内存块的起始地址写入设备的 BAR。这样,操作系统就可以通过读写该内存块中的地址来访问设备的寄存器或内部存储空间。

下图为pci设备配置空间示意图:

nvme_dev_map的执行过程可以主要分为三步:

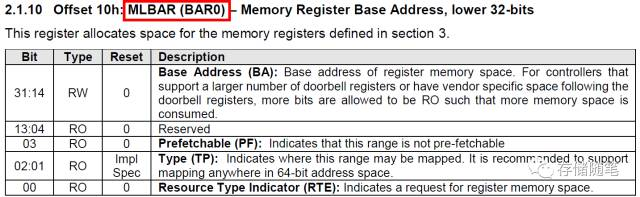

第一步:调用pci_select_bars,其返回值为mask。因为pci设备的header配置空间有6个32位的Bar寄存器(如下图),所以mark中的每一位的值就代表其中一个Bar是否被置起。

第二步:调用pci_request_selected_regions,这个函数的一个参数就是之前调用pci_select_bars返回的mask值,作用就是把对应的这个几个bar保留起来,不让别人使用。

第三步:调用ioremap。在linux中我们无法直接访问物理地址,需要映射到虚拟地址,ioremap就是这个作用。映射完后,我们访问dev->bar就可以直接操作nvme设备上的寄存器了。但是代码中,并没有根据pci_select_bars的返回值来决定映射哪个bar,而是直接映射bar0,原因是nvme协议中强制规定了bar0就是内存映射的基址。

3.2 nvme_setup_prp_pools

主要是创建了两个dma pool,后面就可以通过其他dma函数从dma pool中获得memory了。prp_small_pool里提供的是块大小为256字节的内存,prp_page_pool提供的是块大小为Page_Size(格式化时确定,例如4KB)的内存,主要是为了对于不一样长度的prp list来做优化。

3.3 nvme_init_ctrl

nvme_init_ctrl的作用主要是调用device_create_with_groups函数创建一个名字叫nvme0的字符设备。这个nvme0中的0是通过nvme_set_instance获得的。这个过程中,通过ida_get_new获得唯一的索引值。

3.4 nvme_reset_work

4.nvme_reset_work

1 | static void nvme_reset_work(struct work_struct *work) |

扩展: 线程化与中断上下文的概念(注: 此部分来自维基百科)

中断线程化是实现Linux实时性的一个重要步骤,在linux标准内核中,中断是最高优先级的执行单元,不管内核当时处理什么,只要有中断事件,系统将立即响应该事件并执行相应的中断处理代码,除非当时中断关闭。因此,如果系统有严重的网络或I/O负载,中断将非常频繁,后发生的实时任务将很难有机会运行,也就是说,毫无实时性可言。中断线程化之后,中断将作为内核线程运行而且赋予不同的实时优先级,实时任务可以有比中断线程更高的优先级,这样,实时任务就可以作为最高优先级的执行单元来运行,即使在严重负载下仍有实时性保证。

内核空间和用户空间是操作系统理论的基础之一,即内核功能模块运行在内核空间,而应用程序运行在用户空间。现代的CPU都具有不同的操作模式,代表不同的级别,不同的级别具有不同的功能,在较低的级别中将禁止某些操作。Linux系统设计时利用了这种硬件特性,使用了两个级别,最高级别和最低级别,内核运行在最高级别(内核态),这个级别可以进行所有操作,而应用程序运行在较低级别(用户态),在这个级别,处理器控制着对硬件的直接访问以及对内存的非授权访问。内核态和用户态有自己的内存映射,即自己的地址空间。

正是有了不同运行状态的划分,才有了上下文的概念。用户空间的应用程序,如果想要请求系统服务,比如操作一个物理设备,或者映射一段设备空间的地址到用户空间,就必须通过系统调用来(操作系统提供给用户空间的接口函数)实现。通过系统调用,用户空间的应用程序就会进入内核空间,由内核代表该进程运行于内核空间,这就涉及到上下文的切换,用户空间和内核空间具有不同的地址映射,通用或专用的寄存器组。而用户空间的进程要传递很多变量、参数给内核,内核也要保存用户进程的一些寄存器、变量等,以便系统调用结束后回到用户空间继续执行。所谓的进程上下文,就是一个进程在执行的时候,CPU的所有寄存器中的值、进程的状态以及堆栈中的内容,当内核需要切换到另一个进程时,它需要保存当前进程的所有状态,即保存当前进程的进程上下文,以便再次执行该进程时,能够恢复切换时的状态,继续执行。

同理,硬件通过触发信号,导致内核调用中断处理程序,进入内核空间。这个过程中,硬件的一些变量和参数也要传递给内核,内核通过这些参数进行中断处理,中断上下文就可以理解为硬件传递过来的这些参数和内核需要保存的一些环境,主要是被中断的进程的环境。